Gehört ihr zu den Linux-Nutzern, die ihren eigenen Kernel kompilieren, um noch ein bisschen Leistung aus eurer Hardware zu kitzeln? Sucht ihr ständig nach der besten Distribution, die bei euch am besten laufen könnte, am flüssigsten, am schnellsten? Achtet ihr bei eurem System auf jede Sekunde, die für das Hochfahren draufgeht? Falls ihr diese Frage mit „Ja!“ beantworten könnt, wird der folgende Artikel vielleicht ein wenig unangenehm. Wenn nicht, dann kann er eventuell einen interessanten Gedankenanstoß liefern. Die Suche nach der besten Performance, nach dem optimalen Betriebssystem und der Konfiguration über allen anderen kann nämlich zu einem Paradoxon werden.

Diese ominöse Performance, von der ich hier schreibe, ist im Grunde ein geflügeltes Wort. Klar, es gibt bestimmte Messwerte, anhand derer sich vergleichen lässt, wie performant einzelne Systeme abschneiden. Aber was dabei der Goldstandard ist, was den eigenen Vorstellungen entspricht und wo Verbesserungsbedarf bestehen könnte, lässt sich eigentlich nur schwer messen. Und doch ließt man oft von besserer Performance, zum Beispiel in den Veröffentlichungshinweisen neuer Software-Versionen, Arbeitsumgebungen oder Distributionen. Man könnte fast sagen, dass Performance zu einem gewissen Buzz-Word geworden ist, dass nur zu gern verwendet wird.

Es sind aber bei weitem nicht nur Entwickler, die sich dieses Schlagworts bedienen – oder ihm nacheifern. Auch Endanwender wirken manchmal wie besessen davon: Es gehört zu den Kernargumenten für Distributionen wie Gentoo, dass sie Nutzern die Erstellung einer idealen Installation ermöglichen. Da gehört es dann eben auch dazu, vieles selbst zu machen. Was sage ich, so viel wie nur irgend möglich. Für einige Anwender scheint das einen unglaublichen Reiz darzustellen: Da schwingt ein gewisser Do-It-Yourself-Gedanke mit, dem manche augenscheinlich nicht widerstehen können – oder wollen.

Die Suche nach der besten Performance kann zu einem persönlichen Ziel herausgehoben werden, oder auch ein Versprechen darstellen. Wie genau sich das in der Realität äußert, ist sicherlich von Fall zu Fall unterschiedlich, aber Fakt ist: Die Leistungsfähigkeit des eigenen Systems ist für manche wirklich wichtig. Bei den bisher genannten Beispielen hört es noch lange nicht auf: Manch einer verwendet auf eigentlich ziemlich leistungsfähiger Hardware bewusst extrem leichtgewichtige Software, zum Beispiel einen minimalen Fenstermanager. Klar, dass kann auch an einer persönlichen Vorliebe für den entsprechenden Arbeitsfluss einer solchen Desktopumgebung liegen – aber eben nicht nur. Manche eifern einem leistungsfähigen, minimalen System ohne „Bloat“ so sehr hinterher, dass sich für mich ganz klar die Frage stellt: Warum eigentlich?

Insbesondere aus dem englischsprachigen Raum bekomme ich vermehrt von meinungsstarken Anwendern mit, die sich über vermeintlich aufgeblasene Distributionen, grafische Oberflächen oder Anwendungsprogramme beschweren. Dann wird oft zu leichtgewichtigen Alternativen gegriffen, was ja an sich jeder persönlich entscheiden kann. Für mich wird es genau dann interessant, wenn die Suche nach der optimalen PC-Software ausartet. Dann, wenn sie paradox wird. Ich schreibe hier also nicht von denjenigen, die uralte Hardware zu neuem Leben erwecken, und dazu besser auf ein schmalbrüstiges Betriebssystem setzen wollen. Ich schreibe von denjenigen, die genau das eigentlich nicht müssten, aber es aus irgendeinem Grund doch tun. Nicht, weil die leichtgewichtige Software für sich spricht, sondern weil vermeintlicher Ballast vermieden werden soll.

Das Performance-Paradoxon tritt ein, wenn man den eigenen Rechner für Stunden außer Gefecht setzt, indem man alle Ressourcen in das Kompilieren idealer Software-Pakete steckt, nur damit sich die Bootzeit von acht auf sechs Sekunden verringert. Natürlich ist das für sich betrachtet eine Verbesserung – doch eine Frage muss eben auch erlaubt sein: Zu welchem Preis wird diese Verbesserung eigentlich erzielt? Ich würde ja auch noch mitgehen, wenn man sich einmal das optimale System zusammen schustert und dieses dann pflegt, weil es genau auf den eigenen Anwendungsfall passt. Aber das ist wohl nicht mit dem Konzept der nie enden wollenden Suche nach dem Besten zu vereinen.

Eine kurze Bootzeit rechnet sich langfristig. Aber um diesen perspektivischen Zeitgewinn einfahren zu können, muss man eben auch über Zeit an einem solchen System festhalten. Doch der Drang, noch eine bessere Konfiguration finden zu wollen, setzt im Performance-Paradoxon genau davor ein, genau bevor wirkliche Effektivität erreicht werden könnte. Es bringt nichts, ein System so lange optimieren zu wollen, bis es perfekt ist – nur um es darauf im Versuch, weitere Verbesserungen zu erreichen, wieder über den Haufen zu werfen. Genau das macht das Performance-Paradoxon paradox, widersprüchlich und unlogisch.

Manch einer ist dem Performance-Paradox mehr verfallen, als andere. Aber machen wir uns nichts vor: Wahrscheinlich haben wir uns alle bereits einmal in vergleichbaren Situationen befunden. Der Punkt ist ja auch nicht, Menschen abzusprechen, ständig auf der Suche nach dem besten Betriebssystem sein zu dürfen. Das wäre doch nur ein sinnloses Einmischen, mit dem niemandem wirklich geholfen wäre. Viele wären davon wahrscheinlich eher genervt. Für mich ist das entsprechend auch nicht der Grund, weswegen ich diesen Artikel schreibe. Ich finde nur: Wenn wir immer weiter an unserem System schrauben und dann womöglich zu einer anderen Distro wechseln, brauchen wir uns eines nicht einreden: Dass wir damit Zeit gewinnen oder Energie sparen würden.

Moderne GNU/Linux-Betriebssysteme sind in der Regel auch auf moderne Hardware abgestimmt. Für diejenigen, die alte Hardware weiter verwenden wollen, gibt es ebenfalls genug Auswahl an Projekten. Wer moderne, starke Hardware kauft und dann viel Zeit investiert, diese möglichst wenig zu nutzen, braucht sich das nicht ein- oder schön zu reden. Die eigens gestartete Performance-Suche verbraucht Zeit, die Herstellung eines neuen Computers viel Energie und auch Ressourcen. Stattdessen ist ein solcher Wettlauf mit dem eigenen System vor allem eines: Ein Hobby. Und als solches darf es paradox sein, widersprüchlich, zeitintensiv. Das zu bestreiten, bringt bei genauerer Überlegung nicht so viel. Irgendwie beruhigend ist aber: Vor uns selbst brauchen wir uns für ein Hobby auch nicht wirklich zu entschuldigen.

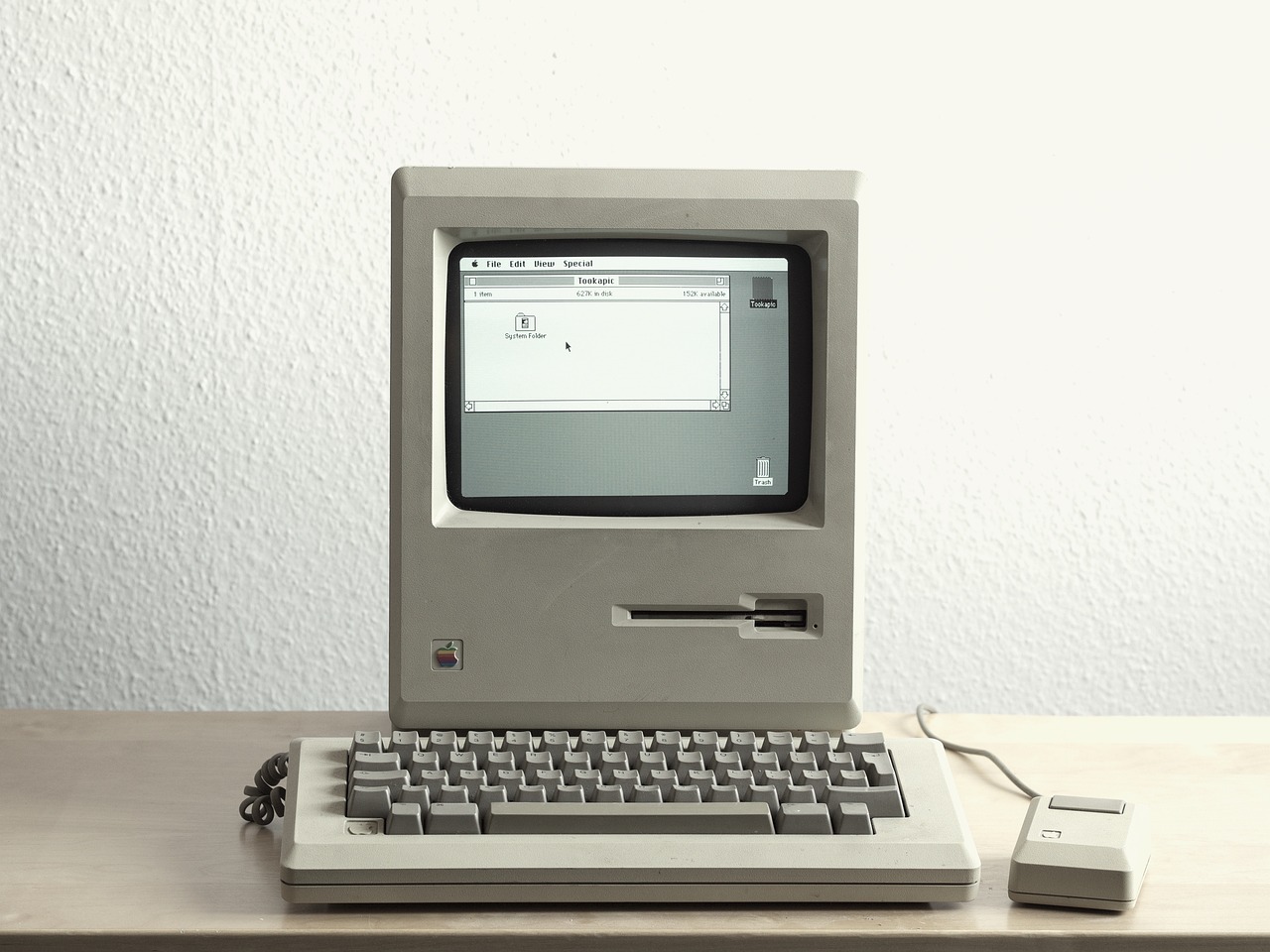

Bildquelle: https://pixabay.com/photos/macintosh-computer-technology-2619617/

Übrigens: Frohe Weihnachten! :)

Ich hatte auch mal Gentoo. Macht schon Spaß, aber für ein System, mit dem man produktiv arbeiten will, ist das natürlich blöd, wenn man viel basteln kann. Weil man das dann auch macht.

Die Lebenszeit, die ich damit verbracht habe, Dinge zu programmieren, die mir fünf Minuten Arbeit sparen, werde ich wahrscheinlich auch nie wieder reinbekommen. Aber es ist ein unterhaltsames Hobby.

Was für ein Bild! Ich konnte mich gar nicht mehr auf den Text konzentrieren. Mein Macintosch aus alten Zeiten. 9 Zoll schwarz-weiß Monitor, das sog. Betriebssystem auf zwei 3,5 Zoll Disketten, völlig unbrauchbare Produktiv Software, die grundsätzlich nach 3 Eingaben abstürzte. Aber ich habe ihn geliebt. Er war mein Erster. Für damalige 900,00 Mark gekauft. Ich vermisse ihn! Ein besseres Bild für den Text hätte es nicht gegeben.

Oh ja da gebe ich dir vollkommen recht, aber ich hätte noch einen anderen Favoriten, den Atari ST mit dem sm124. Wobei mein damaliger Liebling vom meinem Amiga, war mein Sinclair QL und die Verbindung mit QDOS und SuperBasic. Was wir dafür für HW-Erweiterungen gebastelt hatten, war legendär. Das Geschmacksmuster dafür weckt nur positive Erinnerungen die ich heute wirklich vermisse und sie mir wieder herbei wünsche.

Ich bin jetzt erst über den Artikel gestolpert. Warum auch immer. Sehr interessante Betrachtung und doch sehr nah an meiner Situation, die mich zu neuer Hardware getrieben hat. Jüngst habe ich mich nach ca. 10 Jahren dazu entschlossen, mir einen neuen Rechner zu kaufen bzw. daraus ein Projekt zu machen, um ihn komplett selber zusammen zu bauen. Die Auswahl der Komponenten zog sich in vielen Diskussionen von zwei Foren über etliche Web Pages. Ein interessantes Projekt, was auch von den mit Diskutierenden so bestätigt wurde. Warum habe ich mir einen neuen Rechner zugelegt? Ich mag GNOME als DE und das diese Oberflächen nun einmal mehr Leistung benötigen wie so manch anderer minimal DE, muss nicht verschwiegen werden. Auch war meine alte HW nicht mehr ganz zeitgemäß in der Ausstattung von Schnittstellen, das Board lieferte nur eine begrenzte Auflösung für den Monitor, ...und auch meine persönliche Anforderung hatte sich geändert. Klein, leise und sparsam sollte er sein. Lange Rede, kurzer Sinn: Manches Mal braucht es einfach etwas neues und ich finde nichts verwerflich daran, mit der Hardware den flüssigen Betrieb einer Desktop Umgebung der Wahl zu ermöglichen. Ich persönlich würde für einen Desktop Rechner nie auf die Idee kommen, über mäßig viel Zeit in marginale Optimierungen zu stecken. Für z.B. Embedded Systeme in Fahrzeugen, IoT Produkten, medizinischer Bereich, ...da halte ich das für durchaus gerecht fertigt und sinnvoll. Bei Desktop Systemen ist das dann aus Spaß an der Freud oder eben einfach ein Hobby (sei jedem gegönnt). Frohe Festtage!

Mir kommen in diesem Zusammenhang folgende Überlegungen von xkcd in den Sinn:

https://xkcd.com/1205/

https://xkcd.com/1319/

Als (Server-)Performance-Fetischist muss ich hier klar widersprechen. Für den Clientbereich mag das ja alles stimmen, bei Servern nicht wirklich. Wir merken bei der Performance jede noch so kleine sysctl-Konfigurationsänderung oder auch bei php (da sogar am meisten). Natürlich muss man ein gesundes Maß finden zwischen Optimierung und zu tode optimieren (bringt XY überhaupt noch was?)

"Moderne GNU/Linux-Betriebssysteme sind in der Regel auch auf moderne Hardware abgestimmt" - dem stimme ich zu und genau da liegt auch das Problem. Die Module die beim Systemstart geladen werden sind hoffnungslos überfrachtet, da ist derart viel drin, dass der Systemstart unnötig lange dauert. Mag daran liegen, dass Debian keine spezielle Server-Distro anbietet, gleiches Debian für alle ob Server oder Client.

Ein aktuelles Beispiel: Vor ein paar Wochen habe ich unseren Kernel getauscht, von dem linux-image-amd64 auf einen linux-image-cloud-amd64. Der ist nur für Server in Clouds gedacht, hierbei war das Motto der Debian-Entwickler: Räumungsverkauf, es muss alles raus! Das spiegelt sich am meisten in der Dauer eines Reboots wieder, bei uns nur noch ein drittel so lange. Zudem was nicht da ist, macht keinen Ärger. Für was sollte ich auf einem Server USB Kernel Module brauchen die beim Start unnötig mitgeladen werden?

Rechnet man diese Dinge mal "at scale" mit 1000 Servern, sieht die Rechnung gleich wieder anders aus.