Künstliche Intelligenz (KI) wird in unserem täglichen Leben immer häufiger eingesetzt, wobei Systeme wie Siri und Alexa in vielen Haushalten alltäglich werden. Viele Haushalte selbst sind "intelligent", d.h. mit Geräten ausgestattet, die Licht, Heizung und Luft und sogar die Musik steuern können. Diese Systeme werden jedoch oft als "Black Box"-Systeme bezeichnet, weil wir nicht wissen, wie die Daten verarbeitet werden - wie können die Nutzer wissen, warum das Modell diese Vorhersage gemacht hat? Das Aufkommen und die weite Verbreitung von tiefen neuronalen Netzwerken machen die Situation schwieriger, da Menschen nicht logisch interpretieren können, wie Informationen innerhalb von Tausenden von Neuronen verarbeitet werden.

Ein sicherheitskritisches Beispiel für KI-Systeme ist, wenn Ärzte sie zur Diagnose von Krankheiten einsetzen. Diese Systeme tun dies, indem sie Daten mit hoher Geschwindigkeit aufnehmen; so könnten zum Beispiel Tausende von medizinischen Zeitschriften von der KI exponentiell schneller gelesen werden als von einem Menschen. Diese Daten können dann dazu verwendet werden, Vorhersagemodelle zu trainieren, die Ärzten bei der Diagnose von Patienten helfen, diesmal ausgestattet mit weit mehr Datenpunkten als zuvor und in kürzerer Zeit. Man geht davon aus, dass eine Maschine mit all diesen Informationen "bessere" Entscheidungen treffen kann als ein Mensch. Wie können wir jedoch darauf vertrauen, dass eine Maschine solche kritischen Entscheidungen treffen kann, wenn wir die Datenverarbeitungstechniken nicht vollständig verstehen?

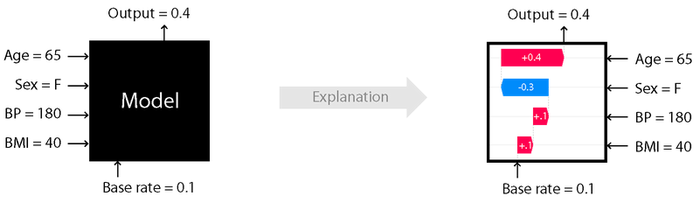

Freie Software unterstützt viele Methoden und Anwendungen, die zu einem besseren Vertrauen in KI-Systeme führen können. So können z.B. die Projekte LIME und SHAP das Ergebnis einer Vorhersage erklären. Um zu veranschaulichen, wie dies funktioniert, sei ein Anwendungsfall für einen Kreditantrag genannt. Auf der Grundlage eines KI-Ergebnisses weist eine Bank einen Kunden zurück, der einen Kreditantrag gestellt hat, aber warum hat der Algorithmus dieses Ergebnis zurückgegeben? Projekte wie die oben genannten, zielen darauf ab, das Modell besser erklärbar zu machen, indem sie Diagramme zur Bedeutung der Merkmale zeigen, d.h. welche Merkmale für das Ergebnis des Modells von Bedeutung waren. Merkmale sind die Inputs, die die Vorhersage erzeugen. Wenn in diesem Beispiel ein wichtiges Merkmal, das zur Ablehnung des Kredits verwendet wurde, "Geschlecht" gewesen wäre, würde dies bedeuten, dass das Modell verzerrt oder falsch ist. Wenn bekannt ist, dass das Modell falsch ist, dann wird ein "Umtrainieren" des Modells zu verbesserten Vorhersagen führen.

Einfluss von Alter, Geschlecht usw. auf die Vorhersage

Diese Projekte tragen dazu bei, Vertrauen in KI-Systeme aufzubauen, indem sie das Black-Box-Modell erklären und die Entscheidungsfindung in sich selbst überprüfen. Durch Open-Source-Projekte wie diese kann aufgrund der Offenheit des prädiktiven Modellierungsprozesses das Vertrauen in das System sichergestellt werden. Es kann den Interessenvertretern die Gewissheit geben, dass das Modell korrekt ist und dass seine Empfehlungen vertrauenswürdig sind.