Lehrer atmen auf, Gutachter freuen sich, Studierende und Redakteure stöhnen laut auf. Das Erkennen von KI-generierten Texten ist nicht einfach, solange die Modelle keine Fakten erfinden oder haarsträubende Unwahrheiten ausspucken, was oft genug der Fall ist. Gestern sind gleich zwei Prüfmaschinen aufgetaucht, die von sich behaupten, die Spreu vom Weizen trennen zu können.

Einer der beiden Aufdecker stammt von OpenAI selbst. Der Dienst nennt sich AI Text Classifier und stellt seine Fähigkeiten mit einigen Limitationen infrage. Der andere Detektiv kommt von der Standford University und verwendet Mathematik, um Generiertes vom Menschgeschriebenen zu unterscheiden. Erstere Methode kann man bereits ausprobieren; bei der Stanford-Mathematik müssen wir uns noch gedulden.

Sofern man einen Account bei OpenAI und einen längeren Text zur Hand hat, kann der AI Text Classifier getestet werden. Die Firma beschreibt den Prüfer wie folgt:

Der Classifier ist ein fein abgestimmtes GPT-Modell, das vorhersagt, wie wahrscheinlich es ist, dass ein Text aus einer Vielzahl von Quellen, wie z. B. ChatGPT, von KI erzeugt wurde. Dieser Klassifikator ist als Werkzeug verfügbar, um Diskussionen über KI-Kenntnisse anzuregen.

Aktuelle Einschränkungen:

- Erfordert ein Minimum von 1000 Zeichen, was ungefähr 150 - 250 Wörtern entspricht.

- Der Classifier ist nicht immer genau; er kann sowohl KI-generierten als auch von Menschen geschriebenen Text falsch kennzeichnen.

- KI-generierter Text kann leicht bearbeitet werden, um dem Klassifikator zu entgehen.

- Bei Texten, die von Kindern geschrieben wurden, und bei Texten, die nicht in englischer Sprache verfasst sind, liegt der Classifier wahrscheinlich falsch, da er in erster Linie mit englischen Inhalten trainiert wurde, die von Erwachsenen geschrieben wurden.

Ich habe es mit einem Text ausprobiert, den ChatGPT für diesen Artikel generiert hat. Der Text beginnt so, und ist insgesamt über 1000 Zeichen lang:

You're correct, GitHub is owned by Microsoft. However, while Microsoft is not a free company, GitHub remains a platform for hosting and sharing open-source software. This means that anyone can use GitHub to create, share, and collaborate on open-source projects, including advent calendars.

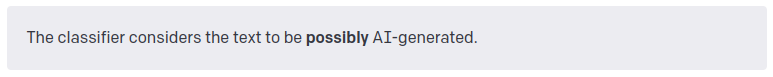

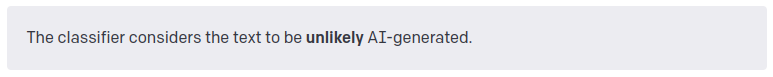

Die Prüfung durch OpenAIs Classifier lautet:

Dann habe ich einen selbst geschriebenen Text prüfen lassen, nämlich den Text dieses Artikels. Das Ergebnis lautet:

Nun wisst ihr es: Ich bin wahrscheinlich eine KI. Dann habe ich den Text des letzten Wochenend-Artikels prüfen lassen:

Bildet euch bitte eine eigene Meinung über die Zuverlässigkeit des AI Text Classifieres.

Beim Stanford-Ansatz kann man leider noch keine Tests durchführen, da er zwar beschrieben, jedoch noch nicht zugänglich ist. Das Ding nennt sich DetectGPT und wird so beschrieben:

Die Wortgewandheit und das Faktenwissen großer Sprachmodelle (LLMs) erhöhen den Bedarf an entsprechenden Systemen, die erkennen, ob ein Text maschinell geschrieben wurde. Beispielsweise können Studenten LLMs verwenden, um schriftliche Aufgaben zu erledigen, so dass Lehrkräfte nicht in der Lage sind, den Lernerfolg der Studenten genau zu bewerten. In dieser Arbeit zeigen wir zunächst, dass Text, der aus einem LLM entnommen wurde, dazu neigt, Bereiche mit negativer Krümmung der logarithmischen Wahrscheinlichkeitsfunktion des Modells zu besetzen. Unter Ausnutzung dieser Beobachtung definieren wir dann ein neues, auf Krümmung basierendes Kriterium, um zu beurteilen, ob eine Passage aus einem bestimmten LLM generiert wurde. Für diesen Ansatz, den wir DetectGPT nennen, ist es nicht erforderlich, einen separaten Klassifikator zu trainieren, einen Datensatz mit realen oder generierten Passagen zu sammeln oder generierten Text explizit mit einem Wasserzeichen zu versehen. Er verwendet lediglich die vom jeweiligen Modell berechneten logarithmischen Wahrscheinlichkeiten und zufällige Störungen der Passage durch ein anderes generisches, vorab trainiertes Sprachmodell. Wir haben festgestellt, dass DetectGPT diskriminanter ist als bestehende Zero-Shot-Methoden für die Erkennung von Modellmustern und insbesondere die Erkennung von gefälschten Nachrichtenartikeln.

Oder in meinen Worten: generierte Texte sind homogener und komplexer als menschliche Texte. Wer sich quälen will, kann hier tiefer graben. ChatGPT (und ähnliche Modelle) funktionieren so, dass das KI-Tool aufgrund vorhandener Datensätze die Wahrscheinlichkeiten für aufeinanderfolgende Wörter analysiert und diese bei einer neuen Anfrage dann aufgrund ihrer Häufigkeit zu wahrscheinlichen Inhalten aneinanderreiht. Die Forscher aus Stanford setzen bei der Unterschiedlichkeit dieser Wahrscheinlichkeiten an.

Sobald DetectGPT zur Verfügung steht, werde ich es testen.

Quellen:

- https://platform.openai.com/ai-text-classifier

- https://ericmitchell.ai/detectgpt/#