Als Ergänzung zur Podcast-Folge 024, die heute Mittag erschienen ist, gibt es diesen Artikel. Tatsächlich gab es zuerst diesen Artikel, bevor wir im Podcast über das Thema gesprochen haben.

Die Gedanken sind nicht frei. Wer das nicht glaubt, dem empfehle ich die Lektüre des Buches Homo Deus von Yuval Noah Harari. In Teil 3, Kapitel 8, weist Harari sehr überzeugend nach, dass Gedanken und Handlungen das Ergebnis von elektrochemischen Prozessen im Gehirn sind. Diese Erkenntnis führt zu der Schlussfolgerung, dass das Bild von der freien Entscheidung des Individuums ein Trugschluss ist. Unsere Gedanken sind eine Funktion: f(x) = g, s, u. Also das Ergebnis von genetischer Prägung, Sozialisation und der Umwelt (Lebenserfahrung). In aktuellem Zusammenhang dazu, steht die Frage, ob Maschinen ein Selbstbewusstsein haben können.

Der Auslöser für diesen Artikel, ist die Diskussion über den Fall LaMDA, der seit einigen Wochen in den Medien kursiert. Kurz gesagt, geht es darum, dass ein Google-Mitarbeiter (Blake Lemoine) dem Language Model for Dialogue Applications ein Bewusstsein zugesprochen hat. Ich möchte hier nicht auf den Unterschied zwischen Bewusstsein und Selbstbewusstsein eingehen, sondern beziehe mich auf Letzteres, weil dieser Begriff eindeutiger ist. Wer sich dennoch dafür interessiert, möge hier nachschauen.

Können Maschinen ein Selbstbewusstsein haben?

Bevor ich auf diese Frage eine Antwort gebe, möchte ich zuerst den Begriff Selbstbewusstsein definieren: "Die Fähigkeit zur Wahrnehmung des eigenen Ichs". Diese Fähigkeit wird nur hoch entwickelten Lebensformen zugestanden, z. B. Menschenaffen oder Menschen. Eine gängige Methode zum Nachweis von Selbstbewusstsein ist der Spiegeltest, in dem der Proband (Hund, Katze, Mensch) ein nur im Spiegel sichtbares künstliches Merkmal erkennen und darauf reagieren soll: "Ralf reisst sich den roten Aufkleber von der Stirn ab".

Diesen (und weitere) Tests bestehen nur Lebensformen mit einem ausgeprägten Neocortex (Grosshirnrinde). Daraus leitet man ab, dass eben dieser, eine notwendige Voraussetzung für die Fähigkeit des Selbstbewusstseins ist. Es geht nicht darum, ob ein Neocortex vorhanden ist oder nicht, sondern um die Komplexität dieser Hirnregion. Komplexität spielt im weiteren Verlauf dieses Artikels eine wichtige Rolle.

Der Neocortex ist ein biologisches Gebilde, welches die Funktion eines neuronalen Netzwerkes abbildet. Dieses Netzwerk ist trainiert (f(x) = g, s, u) und wird laufend weiter trainiert. Dafür sorgt die angeschlossene Sensorik: Haut, Augen, Nase, Ohr, Geschmack, internes Körperfeedback. Um diese Eindrücke zu verarbeiten, stehen dem menschlichen Gehirn ca. 100 Milliarden Nervenzellen zur Verfügung. Auf einem Raspberry Pi bringt ihr das nicht zustande.

Die grössten künstliche neuronale Netzwerke sind GTP-3 mit 175 Milliarden Neuronen, GTP-4 wird im Juli oder August produktiv, mit max. 280 Mrd. Neuronen, Nvidias Megatron-Turing NLG mit 530 Mrd. Neuronen und Googles PaLM Netz mit 540 Mrd. Neuronen. Die Angaben zu diesen Systemen sind sehr unterschiedlich, weshalb ich keine Gewähr zu den Zahlen abgebe. Wichtig ist, dass es sich dabei um NLPs handelt; sie wurden nur auf Spracherkennung und -transformation trainiert. Dazu werden sie mit ca. 500 Mrd. Text-Tupeln aus dem Internet (Crawler, Wikipedia, Bücher, usw.) gefüttert.

Die Zahlen der aktuellen künstlichen Neuronetze mögen beeindruckend hoch sein. Man darf jedoch nicht vergessen, dass sie überwiegend für Sprachverarbeitung trainiert wurden/werden. Zu beachten ist auch, dass sie keine Lebenszeit mit jahrelanger Rückkopplung hinter sich haben. Im Gegensatz dazu wird ein Menschengehirn mit viel breiter ausgelegten Daten trainiert (siehe oben: die sechs Sinne). Ausserdem hat unser Gehirn den Vorteil der ständigen Rückkopplung und Korrekturmöglichkeit.

Szenenwechsel. Woraus besteht ein Mensch?

Der Leib des Menschen besteht aus 13 Grundstoffen, 5 gasförmigen und 8 festen. Die ersteren sind Sauerstoff, Wasserstoff, Stickstoff, Chlor und Fluor, die festen: Kohle, Calcium, Phosphor, Schwefel, Kalium, Natrium, Magnesium und Eisen. Den Hauptbestandteil bildet der Sauerstoff in einem Zustande äusserster Verdichtung.

Das hört sich doch gut an. Lasst uns einen Menschen bauen!

Nun zur Antwort auf die Frage, ob Maschinen ein Selbstbewusstsein haben können. Die Antwort lautet 'Ja'. Aus einer systemischen Sicht betrachte ich Selbstbewusstsein als ein Monitoring der Gehirnprozesse. Voraussetzung dafür sind:

- vielfältige und massenhafte Trainingsdaten

- die Fähigkeit zur Selbstorganisation des Systems

- eine hinreichende Komplexität (100 Mrd. Neuronen scheinen genug zu sein)

Diese Voraussetzungen treffen auf Gehirne von Menschen und einigen Primaten zu; evtl. auch auf weitere hoch entwickelte Lebensformen. Bei der Bewusstseinsbildung im Gehirn ist das Zusammenspiel von ca. 30 unterschiedlichen Arealen nötig.

Es existiert kein übergeordnetes Zentrum, das die Ergebnisse der verschiedenen Areale miteinander vergleicht und koordiniert. Deshalb ist auch nicht anzunehmen, dass das Bewusstsein als höchste Instanz des Gehirns von einem bestimmten Ort aus die ihm untergeordneten Bereiche steuert. Vielmehr wird angenommen, dass es sich um ein Zusammenspiel der Areale im Gehirn handelt. Das allein reicht aber noch nicht aus. Bewusstsein entsteht nur dann, wenn das dezentrale Zusammenwirken einen hohen Grad an Komplexität erreicht und so zu einer neuen Form der Selbstorganisation führt. Das Ergebnis ist eine Art "Inneres Auge", das sich selbst beobachten kann und dadurch Wahrnehmung, Denkprozesse, Gefühle und Handlungen bewusst macht.

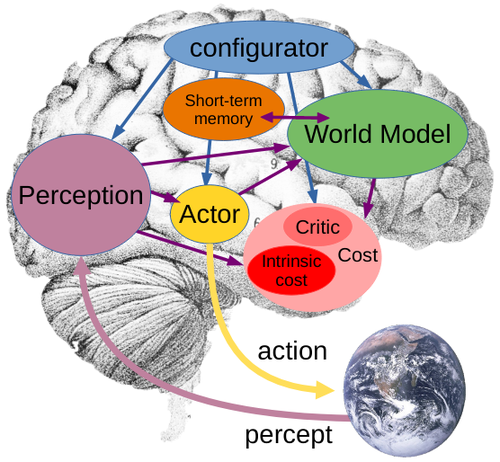

Vor drei Tagen hat einer der Pioniere der KI, Yann LeCun (KI-Chef bei Meta), ein bemerkenswertes Dokument zum Thema geschrieben. Darin erklärt er, dass zum einen das Zusammenspiel unterschiedlicher Inputs wichtig ist und zum anderen beschreibt auch er die interne Rückkopplung (Inneres Auge), welche er "Konfigurator" nennt. Im Gegensatz zu sprach-trainierten Modellen, folgt er dem AGI-Ansatz (Artificial general intelligence), dem ein Weltmodell, bzw. der "Gesunde Menschenverstand" zugrunde liegt.

System-Architektur für eine autonome Intelligenz, Yann LeCun

Alles, was ich bisher beschrieben habe, ist auch mit künstlichen Systemen möglich. Die Grundbausteine (auf atomarer Ebene) sind bei Lebewesen und Maschinen identisch. Die Komplexität ist auf einer vergleichbaren Ebene angekommen. Einzig bei der Trainingsdauer, den Trainingsdaten (Vielfalt plus Menge) und der Rückkopplung hinken die KI's noch hinterher.

Wer neben den wissenschaftlichen Voraussetzungen (Physik, Biologie) noch andere Aspekte geltend machen möchte, hat einen Punkt. Dann reden wir über metaphysische Begriffe wie Seele, Glaube, Religion und den "göttlichen Funken", der uns zu selbstbewussten Wesen macht.

Nur ein lebendes Wesen kann ein Bewusstsein haben.

Was für ein Unsinn. Warum soll das Bewusstsein an ein lebendes Wesen gebunden sein? Dafür gibt es nicht die geringsten Anzeichen. Deshalb lehne ich solche Argumente ab, weil sie weder beweisbar noch der Diskussion zuträglich sind. Solche Behauptungen entspringen einer Überschätzung des Menschseins.

Der Artikel kommt zu einem Ende, und ich muss den Bogen zu freier Software schaffen. Zwei Sachen: Erstens sollten wir als Community immer ein Auge auf die relevanten und gesellschaftsverändernden Technologien richten. Deshalb verweise ich auf die Logbuch-Netzpolitik Folge 432, in der die Überwachung der Algorithmen das Thema ist. Zweitens frage ich mich, welchen Anteil Freie Software an den grossen neuronalen Netzwerken hat, die demnächst unsere Entscheidungen übernehmen werden. Die Gedanken sind nicht frei.

Fazit

- Ich halte LaMDA weder für intelligent noch für selbstbewusst, sondern lediglich für beeindruckend.

- Ich sehe keinen Grund, warum eine Maschine kein Bewusstsein entwickeln sollte.

Nachtrag

Wer sich für dieses spannende Theme interessiert, der empfehle ich diese Folge des SRF Digital Podcasts.

Quellen:

- https://www.wissenschaft-im-dialog.de/projekte/wieso/artikel/beitrag/wo-im-menschlichen-gehirn-ist-das-bewusstsein-lokalisiert/

- https://www.neurologen-und-psychiater-im-netz.org/gehirn-nervensystem/bewusstsein/

- https://arxiv.org/abs/2201.08239

- https://www.heise.de/news/Chatbot-LaMDA-Hat-diese-Google-Software-wirklich-ein-Bewusstsein-entwickelt-7142599.html

- https://cajundiscordian.medium.com/is-lamda-sentient-an-interview-ea64d916d917

- https://de.wikipedia.org/wiki/Bewusstsein

- https://de.wikipedia.org/wiki/Spiegeltest

- https://de.wikisource.org/wiki/Woraus_besteht_der_Mensch%3F

- https://towardsdatascience.com/gpt-4-is-coming-soon-heres-what-we-know-about-it-64db058cfd45

- https://www.heise.de/hintergrund/Deep-Learning-Pionier-LeCun-glaubt-an-neuen-Weg-zur-allgemeinen-KI-7153533.html?seite=2

- https://openreview.net/pdf?id=BZ5a1r-kVsf

- https://en.wikipedia.org/wiki/Artificial_general_intelligence

- https://www.jaai.de/post/mensch-oder-maschine-der-turing-test-einfach-erklaert

"Was für ein Unsinn. Warum soll das Bewusstsein an ein lebendes Wesen gebunden sein? Dafür gibt es nicht die geringsten Anzeichen. Deshalb lehne ich solche Argumente ab, weil sie weder beweisbar noch der Diskussion zuträglich sind. Solche Behauptungen entspringen einer Überschätzung des Menschseins."

Ich sehe das nicht unbedingt als Überschätzung des Menschen. Wenn wir von Bewusstsein sprechen, können wir ja nur unser eigenes als Maßstab nehmen. Und die neuronalen Netze, die du nennst, scheinen ja das Ziel zu haben, bestimmte Funktionen des menschlichen Gehirns zu imitieren. So ein Nachbau mit einem anderen Baumaterial wird wohl oder übel vom Original abweichen, allein schon wegen der unterschiedlichen Entstehung. Unser Bewusstsein entstand als Folge der Evolution, also grob gesagt: Leben, das immer feinfühliger wurde und ab einem gewissen Komplexitätsgrad Intelligenz, dann Bewusstsein, dann Selbstbewusstsein entwickelte. Bei den neuronalen Netzen ist die Intelligenz schon da, und sie wird im Nachhinein trainiert. Ich kann auch mir schwer vorstellen, dass eine Intelligenz Gefühle entwickelt, und die gehören aus meiner Sicht zu einem Bewusstsein (wieder mit dem Mensch als Maßstab) dazu.

Mir kommt es so vor, als ob wir Maschinen entwickeln, die bei uns den Anschein erwecken sollen, dass sie ein Bewusstsein/Selbstbewusstsein haben.

Stimme dir zu, Bewusstsein hat für mich was mit fühlen zu tun. Also ein empfinden was eine Aktion bei mir und anderen auslöst.

Auch halte ich obige Definition für sehr vereinfacht. Fühlen hat führ mich einen komplexen zusammen. Aber seis drum. Egal wie stark man versucht AI/KI zu vermenschlichen, ein geplantes und nur trainiertes system wird nie weitreichende und ausgewogene Entscheidungen treffen können.

Danke, wie immer ein interessanter und informativer Artikel. Ich bin aber in Sachen Selbstbewusstsein wie auch andere hier nicht ganz einverstanden.

"Was für ein Unsinn. Warum soll das Bewusstsein an ein lebendes Wesen gebunden sein? Dafür gibt es nicht die geringsten Anzeichen. Deshalb lehne ich solche Argumente ab, weil sie weder beweisbar noch der Diskussion zuträglich sind. Solche Behauptungen entspringen einer Überschätzung des Menschseins."

Du meinst, dass Bewusstsein nicht an ein lebendes Wesen gebunden ist, weil es keine Anzeichen dafür gibt? Das ist leider keine valide Argumentation. Ich würde sogar lebendes Wesen als Wesen mit Bewusstsein definieren. Wenn man meint, dass Roboter und KI's auf Supercomputer ein Bewusstsein haben, wo unterscheiden sie sich denn nur noch von lebende Wesen?

Das Bewusstsein (bzw. „Selbstbewusstsein”), über den ich rede ist nicht nur „wissen über etwas”, wie man es im verlinkten Wikipedia Artikel zu definieren versucht. Bewusstsein ist das, was jeder bei sich im Moment erlebt. Die Tatsache, dass das, was ich sehe nicht nur im Gehirn wie in ein PC verarbeitet wird, sondern, dass ich das mitbekomme - in anderen Worten, dass meine „Seele” alles sehen kann. Das ist Bewusstsein. Eine KI kann man darauf einstellen, „Aua” Auszugeben oder eventuell zu „sagen”, wenn es durch seine Sensoren z. B. ein schütteln o. ä. aufzeichnet. Aber der Programmierer und kein Mensch wird beim testen dieser Funktion einen schlechten Gewissen bekommen, wenn es dem KI „wehtut” - wenn man es überhaupt so bezeichnen kann. Solche Programme kann man nicht mit Menschen gleichsetzen. Solche Behauptungen entspringen einer Überschätzung der sogenannten „künstliche Intelligenz” - genau genommen kann man Menschen und KI's nicht einmal auf der gleichen Ebene vergleichen, geschweige denn gleichsetzen.

Und würde man trotzdem daran Glauben, dass „künstliche Intelligenz” einen Bewusstsein hat, dann sollte man sich fragen, warum und wann diese entstanden ist? Hat auch ein einfacheres Programm, der nur aus weniger „Neuronen” besteht, einen Bewusstsein? Hat ein einzelner „Neuron” einen Bewusstsein? Wenn ja, dann muss auch ein Programm, der mit einer Tabelle, Funktion, etc... etwas analysiert auch einen Bewusstsein haben. Der oneliner print('odd' if int(input())%2 else 'even')hat somit auch einen einen Bewusstsein? Schliesslich hat es ja ein „wissen über etwas”! Wenn man das bis ans Ende durchzieht, haben alle Computer-Programme, CPUs, Schaltkreise, ... und am Ende auch Steine einen Bewusstsein - das glauben einige sogar, was mMn nicht viel Sinn macht: (https://plato.stanford.edu/entries/panpsychism/#DefiPanp)

Ich kann letztendlich nur mit dem zustimmen, was David S. in seinem Kommentar geschrieben hat: „Mir kommt es so vor, als ob wir Maschinen entwickeln, die bei uns den Anschein erwecken sollen, dass sie ein Bewusstsein/Selbstbewusstsein haben.”